Resumen: En la era digital contemporánea, los Deepfakes, representaciones audiovisuales hiperrealistas generadas por inteligencia artificial, han emergido como una herramienta con potencial tanto para innovaciones benignas como para usos maliciosos. Mientras que los Deepfakes del tipo audiovisual han dominado el discurso público, los Deepfakes de tipo audio presentan desafíos igual o hasta aún más complejos. A pesar de su potencial disruptivo, la detección y regulación de estos Deepfakes sigue siendo un desafío. Este artículo ofrece una visión general de las implicaciones legales, éticas y sociales de esta herramienta de la Inteligencia Artificial, destacando la necesidad de abordar proactivamente sus riesgos en un mundo cada vez más digitalizado.

- Introducción

El término «Deepfake» emergió en 2017, derivado de la fusión de las palabras anglosajonas “Deep” (profundo) y “Fake” (falso). «Deep» alude a «Deep Learning» o «Aprendizaje Profundo», un método de inteligencia artificial que formula algoritmos para que las computadoras adquieran conocimientos de forma autónoma1. Estos algoritmos tienen la habilidad de construir abstracciones de alto nivel, generando patrones audiovisuales tales como imágenes, videos y audios de apariencia tan realista que son equiparables a las grandes producciones cinematográficas de Hollywood con la gran diferencia de que su costo y esfuerzo son mínimos.

Al ser entrenados con vastos conjuntos de datos, estos algoritmos pueden imitar, fusionar rasgos y audio, resultando en representaciones que, en muchos casos, desafían la distinción humana entre realidad y simulación con el objetivo de fabricar réplicas digitales de cualquier persona, ya sea una figura pública o privada, y adaptar esta réplica para que actúe o verbalice según la intención del creador del Deepfake.

Lo preocupante es la accesibilidad de esta técnica. Los softwares de Redes Generativas Antagónicas o por sus siglas en inglés GAN, específicos para la creación de vídeos están disponibles en línea como código abierto, lo que significa que son de libre acceso. Contrarrestar estos vídeos es un reto, ya que el software de Deepfake utiliza un mecanismo que burla a los algoritmos convencionales de detección. Este proceso se basa en la “competencia” entre dos algoritmos: uno superpone una cara en un vídeo de manera repetitiva, mientras el otro evalúa y descarta los resultados menos convincentes del primero (generador y discriminador)2. Esta competencia iterativa refina el producto final, haciendo que los resultados sean sorprendentemente realistas con un ínfimo margen de error.

Dado su potencial para distorsionar la percepción de la realidad y su disponibilidad, los Deepfakes representan importantes retos legales y éticos, abordando cuestiones de privacidad, consentimiento e incluso la seguridad nacional.

- Entre la Innovación y la Manipulación

En primer lugar, la creación de Deepfakes implica una recopilación extensiva de datos del sujeto, muchas veces obtenidos sin su conocimiento o consentimiento, lo que plantea serias preocupaciones sobre la privacidad y la seguridad de la información.

Además, una de las aplicaciones más maliciosas de esta tecnología es la superposición del rostro de un individuo en contenidos que pueden ser publicitarios, desinformativos o incluso pornográficos, sin su autorización, lo que puede causar daños emocionales, psicológicos y reputacionales, a esto se le añade la naturaleza viral de estos contenidos que hará que su eliminación completa de la web sea aún más desafiante.

En el ámbito político y social, los Deepfakes pueden ser herramientas de desinformación, especialmente en contextos electorales. Pueden ser utilizados para difamar a candidatos, distorsionar sus declaraciones o crear escándalos ficticios, desestabilizando procesos democráticos y erosionando la confianza en las instituciones.

- Deepfakes Pornográficos

Los Deepfakes pornográficos representan una de las manifestaciones más dañinas de esta tecnología. Al superponer el rostro de un individuo en contenidos explícitos sin su autorización, estos videos pueden infligir un profundo daño emocional y dañar la reputación de la persona afectada. Tal fue el caso reciente en el Colegio Saint George de Lima, en el cual, un grupo de mujeres adolescentes fueron víctimas del uso de esta tecnología, los medios refieren a que un grupo de estudiantes habían utilizado fotos no intimas de redes sociales de sus compañeras y las habían “desnudado” digitalmente con el uso de herramientas Deepfake. Si bien el Código Penal peruano contempla normativas, como el artículo 154 sobre la «Violación a la intimidad», que podrían ser relevantes en casos de Deepfakes pornográficos, no se abordan directamente los retos específicos que estos presentan3. Por ejemplo, el artículo 154-B, que sanciona la difusión de material sexual, no toma en cuenta la eventualidad de que dicho material haya sido generado o alterado mediante Deepfakes4.

El problema clave para sancionar de manera efectiva a quienes manipulan material audiovisual, perjudicando la integridad de adolescentes, radica en que no emplean contenido íntimo auténtico, sino herramientas que crean la ilusión de material real. En otras palabras, lo que se observa no es la persona desnuda en sí, sino una recreación digital tan detallada que parece auténtica.

- Deepfakes de Audio

Más allá de las falsificaciones visuales, existen Deepfakes que replican la voz de un individuo con una precisión alarmante. Estas imitaciones vocales han sido empleadas en fraudes telefónicos, engañando a las personas al hacerles creer que interactúan con alguien de su confianza. Por ejemplo, los delincuentes pueden aprovechar estos Deepfakes auditivos para solicitar préstamos o efectuar operaciones financieras, suplantando la identidad de la víctima5. Esta modalidad de fraude es particularmente inquietante, dado que las víctimas pueden enfrentar dificultades para probar que no dieron consentimiento para tales acciones.

Si bien las estafas telefónicas son una preocupación inmediata, los Deepfakes de voz tienen el potencial de ser utilizados en una variedad de escenarios maliciosos:

- Manipulación de Asistentes Virtuales: Muchos dispositivos modernos, desde smartphones hasta sistemas de seguridad del hogar, se controlan mediante comandos de voz. Un Deepfake de voz podría ser utilizado para dar órdenes no autorizadas a estos dispositivos, comprometiendo la seguridad y privacidad del usuario.

- Fraude en Servicios Bancarios por Voz: Muchos bancos ofrecen servicios telefónicos que utilizan la voz como una forma de autenticación. Un Deepfake de voz podría ser utilizado para acceder y manipular cuentas bancarias.

- Desinformación y Propaganda: Los Deepfakes pueden ser utilizados para crear mensajes de voz falsos, atribuidos a líderes políticos o empresariales, que contengan declaraciones controvertidas o incriminatorias. Las ramificaciones políticas y económicas podrían ser enormes.

- Amenazas y Extorsión: Los delincuentes podrían usar Deepfakes de voz para crear mensajes amenazantes, haciéndose pasar por alguien de confianza o autoridad.

- Dificultades en la Detección

A diferencia de los Deepfakes visuales, que pueden ser detectados mediante inconsistencias en la iluminación o alineación o parpadeo, los Deepfakes de voz son más difíciles de discernir. La calidad del medio a través del cual se escucha el audio puede agravar el problema. Por ejemplo, en una llamada telefónica, donde la calidad del sonido puede ser inferior, es aún más complicado distinguir una voz auténtica de una fabricada. Esto se empeora con la mejora constante de la tecnología detrás de los Deepfakes, que hace que las imitaciones sean cada vez más sofisticadas y difíciles de detectar incluso para expertos en el área.

- Implicaciones Sociales y Psicológicas

La proliferación de Deepfakes auditivos puede tener repercusiones profundas en la forma en que la sociedad percibe y confía en el contenido auditivo. A medida que estas falsificaciones se vuelven más comunes, podría surgir un escepticismo generalizado hacia cualquier grabación de voz, independientemente de su autenticidad. Esta desconfianza no solo afectaría a los medios de comunicación y al periodismo de investigación, donde las grabaciones de voz a menudo sirven como pruebas cruciales, sino que también podría infiltrarse en la vida cotidiana. Las personas estarían más propicias a dudar de grabaciones de voz en situaciones legales, conversaciones telefónicas importantes o incluso mensajes de voz de seres queridos. A largo plazo, esto podría erosionar la confianza en las comunicaciones auditivas y requerir la implementación de sistemas de verificación más robustos para garantizar la autenticidad del contenido.

- Implicaciones Legales

El surgimiento de los Deepfakes ha revelado varias lagunas en el marco legal existente. La legislación actual enfrenta dificultades para abordar casos de difamación, falsedad y violación de la privacidad perpetrados mediante Deepfakes. Además, la atribución y la responsabilidad se vuelven difusas, ya que determinar la autoría de un Deepfake puede ser extremadamente complicado. En la gran mayoría de países incluidos el Perú las leyes actuales no están preparadas para abordar los desafíos específicos que presentan los Deepfakes, lo que lleva a un vacío legal preocupante.

- Desafíos en la Regulación

Regular los Deepfakes implica equilibrar la libertad de expresión con la protección contra daños. La creación de leyes específicas para Deepfakes debe considerar la prevención del abuso, sin coartar la innovación tecnológica y la creatividad. Además, la naturaleza transfronteriza de los medios digitales exige una cooperación internacional para abordar el fenómeno de manera efectiva. Las plataformas de redes sociales y los proveedores de servicios en línea también tienen un papel crucial en la detección y eliminación de contenido Deepfake malicioso.

- Propuestas de Solución

Para mitigar los riesgos asociados con los Deepfakes, se proponen varias soluciones:

- Desarrollo de Tecnología de Detección: Invertir en la investigación y desarrollo de tecnologías capaces de detectar Deepfakes de manera eficiente, precisa y rápida. Estas herramientas pueden ser esenciales para plataformas en línea y agencias de noticias.

- Educación y Concienciación Pública: Implementar programas educativos masivos para familiarizar y concienciar al público sobre la Inteligencia Artificial y los Deepfakes, así como, fomentar el pensamiento crítico en el consumo de medios digitales.

- Marco Legal Especial: Desarrollar legislación específica que aborde los desafíos únicos presentados por los Deepfakes, estableciendo responsabilidades claras y sanciones adecuadas incluyendo una modificación a a reciente la Ley 318146 sobre el uso ético y responsable de la Inteligencia Artificial.

- Cooperación Internacional: Fomentar la colaboración entre países y organizaciones para compartir información, tecnología y estrategias para combatir los Deepfakes.

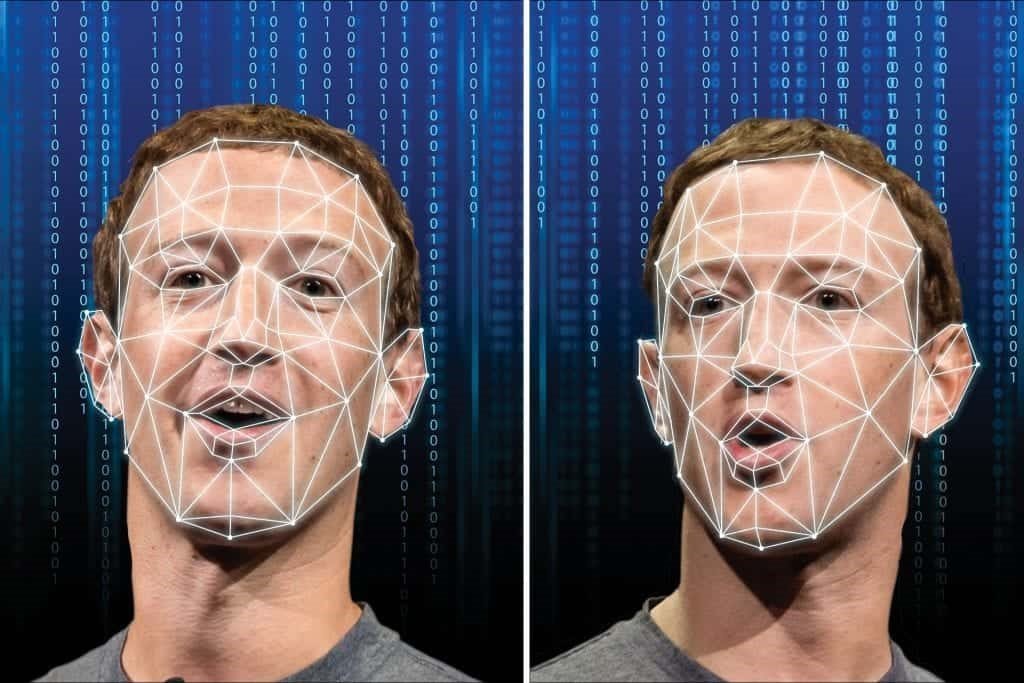

- Deepfakes como Herramienta Artística y de Protesta

Resulta relevante señalar que los Deepfakes han sido objeto de preocupación debido a su potencial para la desinformación y el daño, sin embargo, también han emergido como una herramienta poderosa para la expresión artística y la protesta social. Un ejemplo notable es el Deepfake de Mark Zuckerberg7, en el que se alegaba que vendía información de los usuarios de Facebook. Aunque este video fue una creación ficticia, sirvió como una forma provocativa de comentar sobre las preocupaciones de privacidad y el poder de las grandes empresas tecnológicas.

Este uso de los Deepfakes subraya la importancia de no demonizar la tecnología en sí misma, sino de considerar cómo se utiliza. En manos de artistas y activistas, los Deepfakes pueden ser una herramienta valiosa para arrojar luz sobre cuestiones sociales y políticas, y para desafiar a las instituciones de poder.

Conclusión

Los Deepfakes, con su capacidad para alterar la percepción de la realidad, representan un desafío significativo en el panorama político legal y social actual. Abordar este fenómeno requiere un enfoque multifacético que combine tecnología, educación, legislación y cooperación internacional. Es esencial que cualquier discusión o legislación sobre el tema reconozca y respete la dualidad de esta herramienta, que puede ser tanto perjudicial como beneficiosa, dependiendo de cómo y con qué intención se utilice.

Referencias:

[1] Mahmud, B. U., & Sharmin, A. (2021). Deep insights of deepfake technology: A review. arXiv preprint arXiv:2105.00192.

[2] Joey Mach. (2019). Deepfakes: The Ugly, and The Good. Towards Data Science. https://towardsdatascience.com/deepfakes-the-ugly-and-the-good-49115643d8dd

[3] Miranda, O. (2023). El peligro de la pornografía deepfake. La República. https://larepublica.pe/domingo/2023/09/03/el-peligro-de-la-pornografia-deepfake-porno-chorrillos-inteligencia-artificial-111374

[4] Lavanda Oliva, M. (2021). Deepfake: Cuando la inteligencia artificial amenaza el Derecho y la Democracia. Lawgitec (2ª edición)

[5] Flitter, E., & Cowley, S. (2023). Los ‘deepfakes’ de voz van a por tus ahorros. The New York Times.

[6] Ley N° 31814. Ley que promueve el uso de la inteligencia artificial en favor del desarrollo económico y social del país.

[7] Metz, R. (2019). A deepfake video of Mark Zuckerberg presents a new challenge for Facebook. CNN Business. Recuperado de: https://edition.cnn.com/2019/06/11/tech/zuckerberg-deepfake/index.html

Bibliografía:

- Flitter, E., & Cowley, S. (2023). Los ‘deepfakes’ de voz van a por tus ahorros. The New York Times.

- Joey Mach. (2019). Deepfakes: The Ugly, and The Good. Towards Data Science. https://towardsdatascience.com/deepfakes-the-ugly-and-the-good-49115643d8dd

- Lavanda Oliva, M. (2021). Deepfake: Cuando la inteligencia artificial amenaza el Derecho y la Democracia. Lawgitec (2ª edición)

- Ley N° 31814. Ley que promueve el uso de la inteligencia artificial en favor del desarrollo económico y social del país.

- Mahmud, B. U., & Sharmin, A. (2021). Deep insights of deepfake technology: A review. arXiv preprint arXiv:2105.00192.

- Metz, R. (2019). A deepfake video of Mark Zuckerberg presents a new challenge for Facebook. CNN Business. Recuperado de: https://edition.cnn.com/2019/06/11/tech/zuckerberg-deepfake/index.html

- Miranda, O. (2023). El peligro de la pornografía deepfake. La República. https://larepublica.pe/domingo/2023/09/03/el-peligro-de-la-pornografia-deepfake-porno-chorrillos-inteligencia-artificial-111374.