“Nothing in life is to be feared, it is only to be understood. Now is the time to understand more, so that we may fear less”. ― Marie Curie

Probablemente esté agotado (o asustado) ya de tanto leer sobre los posibles impactos de la “inteligencia artificial” (IA) y propuestas para regularla e incluso “pausarla”. Eliezer Yudkowsky, un investigador del Machine Intelligence Research Institute de los Estados Unidos de América, ha llegado a sugerir —partiendo de la premisa ciertamente cuestionable de que el resultado inevitable de tener una “super inteligencia artificial” mayor a la humana será la aniquilación de nuestra especie en un corto tiempo— que debería monitorearse el poder de computación de los países e incluso bombardearse a los que desarrollen inteligencia artificial fuera del restrictivo marco que se propone. Cito textualmente para que no se considere que exagero:

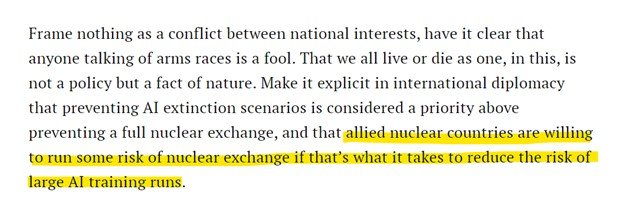

“Hagamos explícito en el Derecho Internacional que la prevención de escenarios de extinción causados por la IA se considera una prioridad, por encima de la prevención de una guerra nuclear total; y que los países aliados con capacidad nuclear están dispuestos a correr algún riesgo de tal guerra si eso es lo que se necesita para reducir el riesgo de grandes carreras de entrenamiento de IA”[1].

Es necesario, sin embargo, poner las cosas en perspectiva. No cabe duda de que la IA puede ser revolucionaria ni de que tendrá un gran impacto en la economía y en las relaciones humanas en general. Como toda tecnología, su introducción nos presenta beneficios y también costos y riesgos. Consideramos que es importante, en primer lugar, entender qué es la IA y luego, sobre la base de la mejor evidencia disponible, identificar qué riesgos o “fallas de mercado” son reales. Posteriormente esos riesgos o costos se deben contrapesar a los beneficios ofrecidos. Luego de ello, recién podemos identificar qué tipo de regulación puede ser realmente necesaria y efectiva; y con qué alcance.

¿Qué es la IA?

El concepto de IA es elusivo. El término “inteligencia” es engañoso, por lo menos por ahora, porque las computadoras están muy lejos de llegar a pensar como lo hace un ser humano, a tener lo que llamamos sentido común, o a adaptarse al amplio rango de situaciones las que podemos adaptarnos los seres humanos. El término se usa para denotar que las computadoras actúan como si fueran inteligentes, al “razonar” o “crear” nuevas respuestas o realizar las acciones solicitadas. En la práctica, se trata de algoritmos, funciones matemáticas que transforman un input en un output[2]. Estas funciones y los inputs que se utilizan en ellas son creadas por humanos. Son humanos los que deciden que hará la IA con la data que se le ingresa.

Claro, así dicho parece muy sencillo y poco importante; pero estas funciones están respaldadas por enormes bases de datos (información que los seres humanos no pueden retener ni procesar rápidamente) y además por un proceso de machine learning; que les permite mejorar de forma “autónoma”.

Eso no quiere decir que por muy poderosa que sea esta herramienta, vaya a generar que las computadoras tengan consciencia o voluntad de realizar algo. En un episodio del podcast Econtalk, de Russ Roberts, el fatalista autor al que hacemos referencias en la introducción del presente artículo, Eliezer Yudkowsky, trata de explicar como, más allá de no tener consciencia (ese no sería el problema); la IA podría pasar a tener objetivos propios o “sub-objetivos”. La explicación deja mucho de desear. Más allá de hacer un paralelo con los humanos y cómo desarrollamos deseos que no necesariamente se relacionan con nuestras necesidades evolutivas, hay un eslabón (o varios) que falta entre el chat que nos responde preguntas y “Skynet”[3].

En otro episodio del mismo podcast, Tyler Cowen, economista y polímata de la Universidad George Mason, es mucho más ponderado. Si bien no descarta ninguno de los riesgos asociados al uso de la IA, invita a aquellos que están proponiendo que existen riesgos existenciales a presentar evidencia o algún modelo matemático de ello… y sobre todo, a no pasar por encima del Estado de Derecho y los derechos humanos en el camino.

¿Qué riesgos son reales, ameritan intervención estatal y no están cubiertos por la legislación vigente?

Sería fácil desestimar, por alarmistas, riesgos como los expuestos en la introducción, pero, ¿qué tan reales son? Según reporta The Economist, pocos investigadores creen que estamos cerca a tener una “superinteligencia” que sea amenazante para la raza humana. La revista cita un experimento realizado por Ezra Karger, de la Reserva Federal de Chicago y Philip Tetlock, de la Universidad de Pennsylvania; que compararon las predicciones de los expertos en IA con las de “superpredictores” (“superforecasters”), personas que cuentan con un sólido record de predicciones y que han sido entrenados para evitar sesgos cognitivos. Los expertos en IA calcularon una probabilidad de 3.9% de una catástrofe existencial (con menos de 5,000 seres humanos sobreviviendo), mientras que los superpredictores calcularon una probabilidad de 0.38% a tal desenlace. ¿Cuál sería la diferencia?: los expertos en IA tienen un “sesgo de selección” (por algo escogieron ese campo), y son menos sensible a las diferencias entre pequeñas probabilidades.

Por supuesto, siendo un riesgo tan grande (nada menos que la extinción de la raza humana) una probabilidad de 0.38% igual puede ser preocupante; pero lo que demanda dicha situación es tener cautela; pero no tener cautela a cualquier costo[4].

Debemos estar atentos a cualquier desarrollo o nuevo uso que se pueda dar a la inteligencia artificial y regular “con bisturí y no con mazo” parafraseando una metáfora que se usó en la pandemia del Covid-19 para diseñar y aplicar políticas públicas de manera precisa.

Lo anterior implica tener en cuenta también algo que parece ser ignorado en este debate: cómo reaccionaremos ante la AI. Albrecht (2023) usa el ejemplo del cambio climático (en el extremo, también un riesgo existencial). La contaminación nos impone costos, así que incluso desde una perspectiva privada existen incentivos para minimizar los riesgos Y aunque estamos muy lejos de llegar a una solución; existen países que se están decarbonizando. Los países y muchas grandes acciones están tomado acciones para controlarlo. Lo mismo pasa con la IA. La gente va a demandar mecanismos de seguridad. Empresas como Microsoft tienen incentivos legales y reputacionales grandes para evitar que la IA genere daños a terceros.

Con todo, consideramos que, a la fecha, existen riesgos mucho más concretos que la aniquilación de la raza humana, a los que debemos hacer frente ya:

- Sesgos y discriminación, sobre todo cuando la IA es utilizada para prestar servicios públicos. Decidir quién accede a un subsidio o a una pensión, por ejemplo;

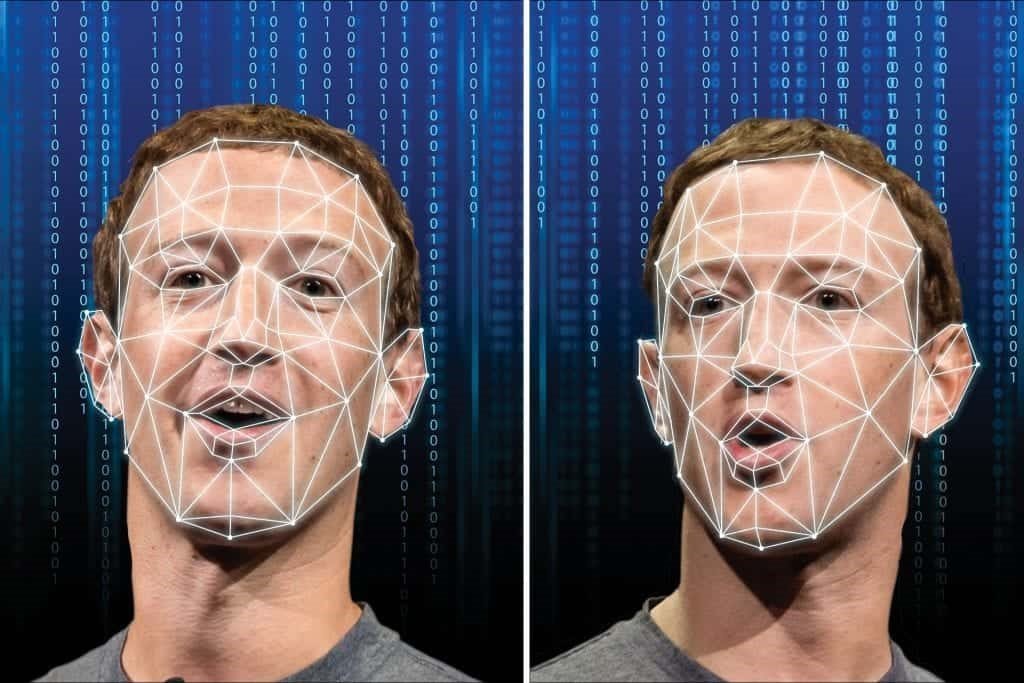

- Vigilancia masiva. Principalmente por parte de los Estados. Piensen, por ejemplo, en el uso de reconocimiento facial en las calles. Aunque esto se haga por motivos de seguridad, puede tener impactos negativos significativos sobre la privacidad de las personas.

- Desinformación. Este fenómeno, por supuesto, es más antiguo que las mismas computadoras; pero los “grandes modelos de lenguaje” (“LLM” por sus siglas en inglés) como ChatGPT pueden potenciarlo al reducir los costos de generar miles de tweets o notas falsas.

- Violación de derechos de propiedad intelectual, al crear imágenes y textos que combinan otros (miles o millones) de imágenes o textos sin respetar o siquiera atribuir la autoría original.

- Violación de los derechos a la imagen de las personas, como el uso de “deep fakes” para explotar la imagen de terceros de manera no autorizada.

- Riegos de hacking o manipulación de sistemas militares. Nuevamente estos son riesgos que ya existen; pero la IA puede potenciarlos.

Aunque carecemos del expertise para afirmarlo categóricamente, tenemos la impresión todos estos riesgos pueden gestionarse razonablemente bien con las leyes vigentes; o con actualizaciones menores a éstas. No me queda duda, por ejemplo, de que la legislación que protege la imagen de las personas, como el derecho a la imagen consagrado en el Código Civil y la Ley de Protección de Datos Personales, es suficiente para contrarrestar el uso de la imagen e información de las personas sin su consentimiento. El enforcement será un reto, por supuesto, considerando la gran escala de este fenómeno. Pero esa escala lo que demanda es estar mejor enfocados en los riesgos; no estar demasiado preocupados por los que son remotos.

Esto puede ser difícil, sin embargo. Como hemos notado en otro artículo:

“Es notoria la tendencia de los abogados (aunque no solamente de los abogados) de pensar que cada fenómeno social nuevo necesita una nueva ley. ‘Entran en trompo’ cada vez que una nueva tecnología o fenómeno parece no adecuarse al derecho existente o no tiene una ‘ley con nombre propio’. Pareciera que estamos ante un “horror al vacío legislativo”, derivado acaso de una falta de capacidad de abstracción suficiente que permita entender como los nuevos fenómenos sí pueden ser perfectamente ser subsumidos dentro de los supuestos de hecho de la legislación vigente”.

¿Cómo regulamos la IA (o mejor dicho, ciertos usos de ella)? ¿Cómo evitamos los riesgos de sobre-regulación?

Esta es, aclaremos desde ya, una pregunta mal elaborada; demasiado amplia. Si, como hemos precisado líneas arriba, es difícil definir qué es la IA, ¿cómo podemos regularla de manera tan amplia? Esa no es la pregunta. Lo que tenemos que hacer es enfocarnos, en ese sentido, en los riesgos que hemos identificado líneas arriba. Luego, seguir monitoreando los nuevos usos de la tecnología y promulgar regulación, previamente por supuesto a un adecuado análisis de impacto regulatorio que nos permita ser quirúrgicos: desincentivar las conductas o usos realmente peligrosos o que generan “externalidades” sin estorbar los usos que generan beneficios sociales; y hacer esto de manera eficiente (en términos legales, que la medida sea razonable y proporcional).

No tiene razón de ser, en ese sentido, crear una “FDA” o un “OSI” para la IA, que emita aprobaciones previas para el uso de cada nuevo producto o servicio basado en inteligencia artificial; cada nuevo algoritmo. No tiene sentido tampoco establecer regulaciones de precios o de condiciones de comercialización para esta tecnología. Ese tipo de regulación “te digo qué hacer y te multo” (“command and control”) lo único que hará es desincentivar la innovación y más bien prevenir que como sociedad gocemos de los beneficios que nos puede traer la agricultura; ya documentados (Thierer, 2022) en los campos de la salud, agricultura, entretenimiento, transporte y logística; y, en general, en términos de crecimiento y productividad.

La sabiduría tiene una connotación distinta a la de la inteligencia, incluyendo la habilidad de captar las complejidades de la realidad humana y adaptarse a los cambios. Usémosla también al diseñar la regulación.

BIBLIOGRAFÍA:

ALBRECHT, Brian. An equilibrium perspectiva on AI. En: Economic Forces. 30 de marzo de 2023. Disponible en: https://pricetheory.substack.com/p/an-equilibrium-perspective-on-ai

DEKEL, Roy (2023). Despite How the Media Portrays It, AI Is Not Really Intelligent. Here’s Why. En: Entrepreneur. 15 de marzo de 2023. Disponible en: https://www.entrepreneur.com/science-technology/despite-how-the-media-portrays-it-ai-is-not-really/446894

THIERER, Adam (2022). Artificial Intelligence Primer: Definitions, Benefits & Policy Challenges. 2 de diciembre de 2022. Disponible en: https://medium.com/@AdamThierer/artificial-intelligence-primer-definitions-benefits-policy-challenges-4c20a1fcf465

YUDKOWSKY, Eliezer (2023). Pausing AI Developments Isn’t Enough. We Need to Shut it All Down. En: TIME. 29 de marzo de 2023. Disponible en: https://time.com/6266923/ai-eliezer-yudkowsky-open-letter-not-enough/

[1] Traducción libre del siguiente texto: “Make it explicit in international diplomacy that preventing AI extinction scenarios is considered a priority above preventing a full nuclear exchange, and that allied nuclear countries are willing to run some risk of nuclear exchange if that’s what it takes to reduce the risk of large AI training runs”. En: YUDKOWSKY (2023).

[2] “It is important to recognize that AI is not truly intelligent but rather well-trained to perform specific tasks within a predetermined set of parameters. AI lacks the ability to think independently, understand the nuances of human behavior and make decisions based on common sense”. Ver: DEKEL (2023). Disponible en: https://www.entrepreneur.com/science-technology/despite-how-the-media-portrays-it-ai-is-not-really/446894

[3] Para los que no lo conocen, Skynet es la denominación que recibe la inteligencia artificial que decide exterminar a la raza humana en la saga “Terminator” de James Cameron, protagonizada por Arnold Schwarzenegger.

[4] Aunque para algunos nunca se podría tener “demasiada cautela”, los daños producidos por excesos en la precaución están documentados. Ver: ZÚÑIGA, Mario (2012). ¿Más vale prevenir que lamentar? repensando el denominado “principio precautorio”. Working Paper presentado a la XVI Conferencia Anual de la Asociación Latinoamericana e Ibérica de Economía y Derecho ALACDE. 18 de junio de 2012. Disponible en: https://decomunsentido.files.wordpress.com/2012/06/mzp-principio-precautorio-v-2-1.pdf.